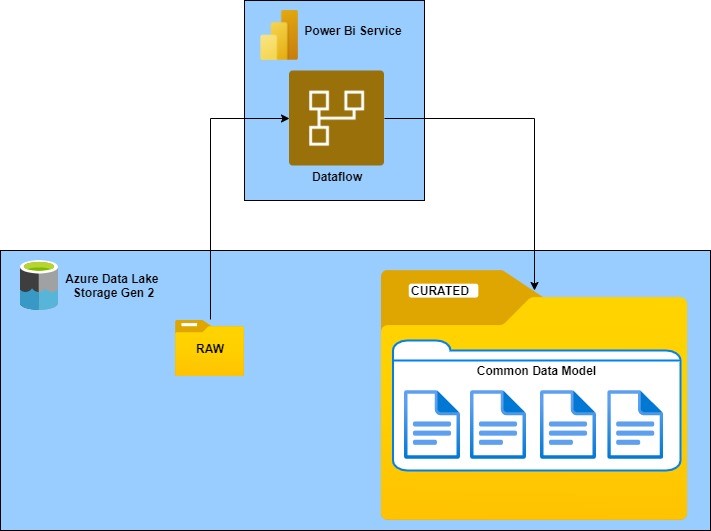

En este post os queremos explicar cómo utilizar el almacenamiento de Azure Data Lake Storage Gen2 (ADLSg2) para crear nuestro datawarehouse utilizando dataflows de Power Bi como origen de nuestra información.

Con este planteamiento, el almacenamiento de Azure Data Lake Storage Gen2 (ADLS Gen2) se va a comportar como un repositorio donde tendremos centralizado los datos de nuestro negocio. Partiremos de unos datos bruto (capa raw o bronce) almacenados en el data lake. Utilizaremos dataflows de Power Bi como herramienta etl para conseguir que nuestros datos estén listos para ser consumidos (capa curated o gold) por las distintas aplicaciones. Estos datos ya preparados quedarán almacenados de nuevo en el data lake y tendremos la oportunidad de hacer uso de ellos utilizando el formato Common Data Model (CDM) o el sistema de archivo del ADLS Gen2.

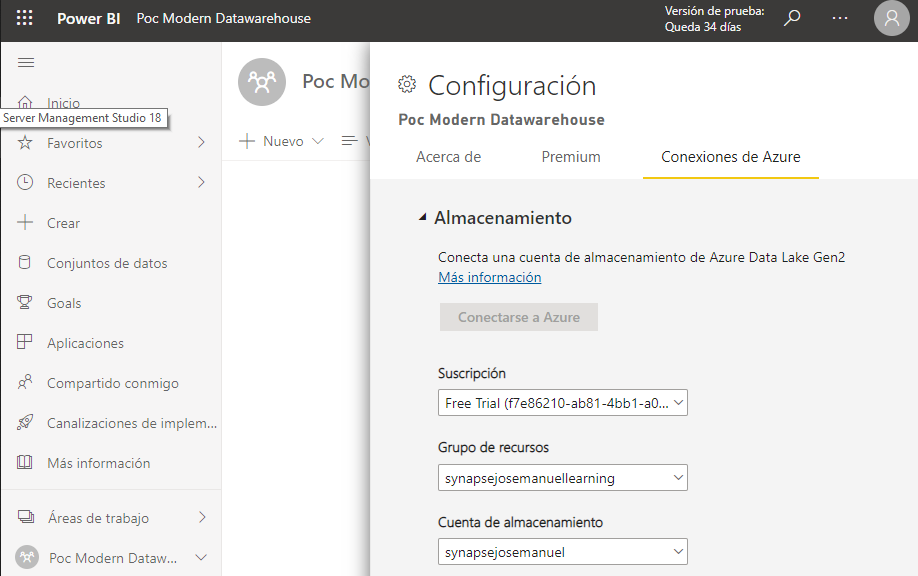

Configuración del almacenamiento de azure data lake al área de trabajo de Power Bi

Los datos que se usan con Power BI, de forma predeterminada, se almacenan en el almacenamiento interno proporcionado por Power BI. Este almacenamiento propio, incluido en la licencia de Power Bi, está restringido a su uso solo por Power Bi, limitando las capacidades de reutilización.

Al asociar el almacenamiento de ADLS Gen2 con dataflows en al área de trabajo de Power Bi, nos va a permitir utilizar nuestro propio almacenamiento a nivel de inquilino para almacenar los dataflows. Veamos como asociarlo:

En un área de trabajo del servicio Power Bi donde aún no existan dataflows, vaya a “configuración del área de trabajo” y en la pestaña “Conexiones de Azure” podremos asociar nuestro almacenamiento de ADLS Gen2 proporcionando los datos sugeridos en las listas desplegables.

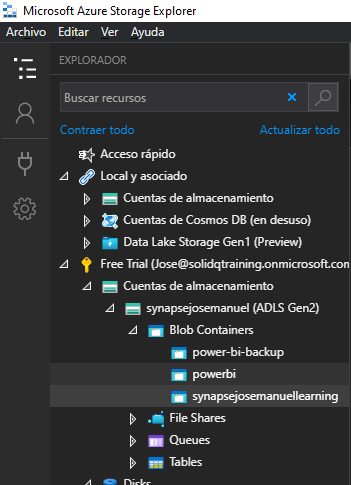

Power BI configura automáticamente la cuenta de almacenamiento con los permisos necesarios y configura el sistema de archivos de Power BI en el que se escribirán los datos. En este momento, todos los datos del flujo de datos de esta área de trabajo escribirán directamente en este sistema de archivos, que se puede usar con otros servicios de Azure, con lo que se crea un solo origen para todos los datos de la organización o del departamento.

Creación de dataflow en Power Bi utilizando como origen de datos nuestros datos brutos almacenados en el ADLS Gen2

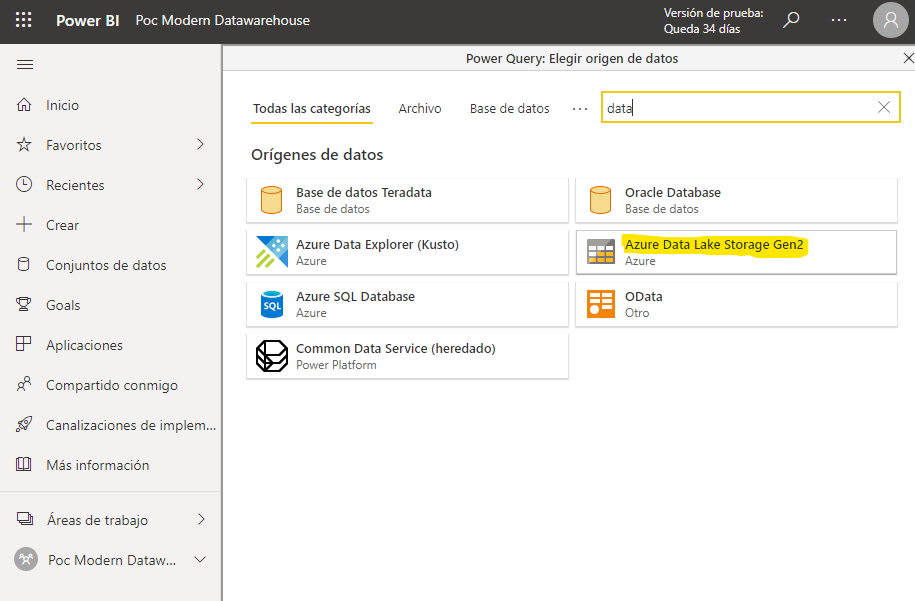

Ahora vamos a crear un dataflow para aprovechar sus capacidades como herramienta etl para generar nuestros datos listos para ser consumidos

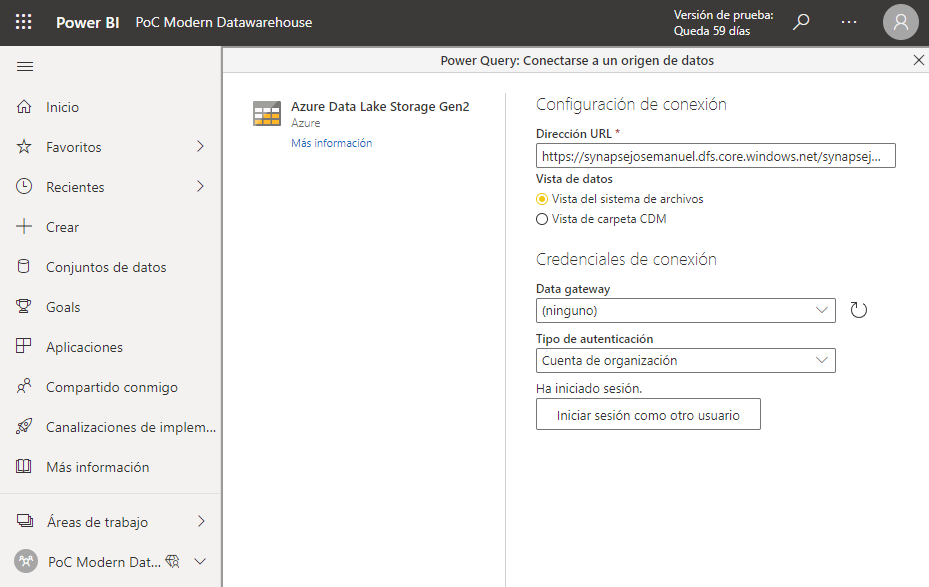

En el área de trabajo donde hemos asociado el almacenamiento de nuestro ADLS Gen2, crearemos un nuevo dataflow. Como origen de datos utilizaremos “Azure Data Lake Storage Gen2”

Configuraremos la conexión con los datos de nuestra cuenta de almacenamiento.

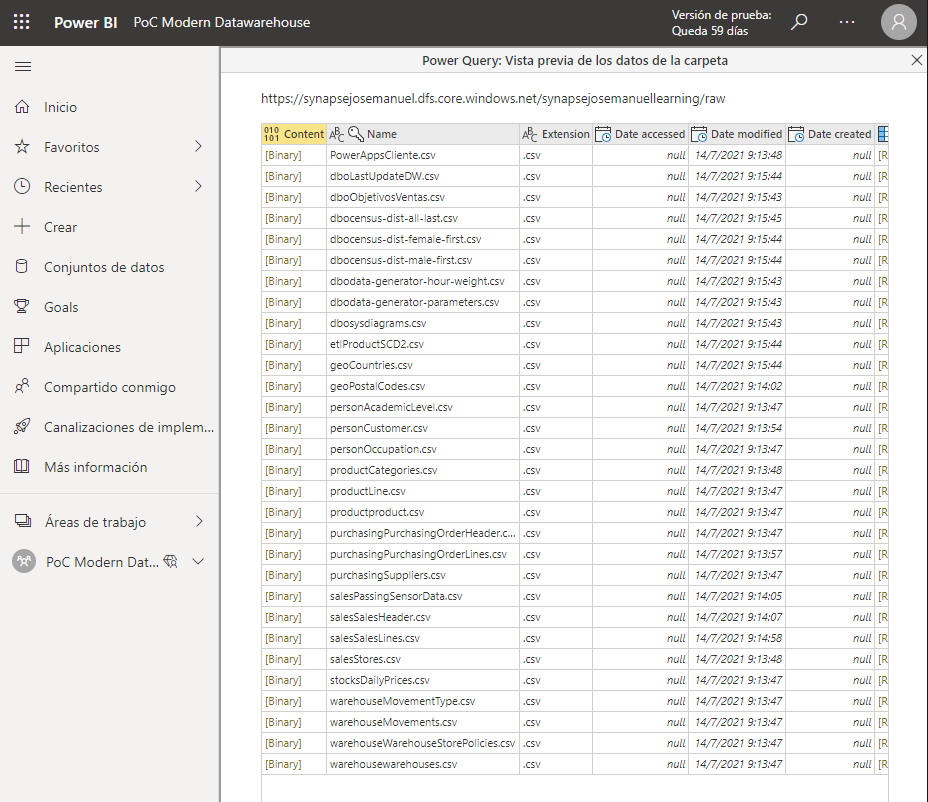

Y tendremos disponibles todos nuestros ficheros de la dirección URL especificada.

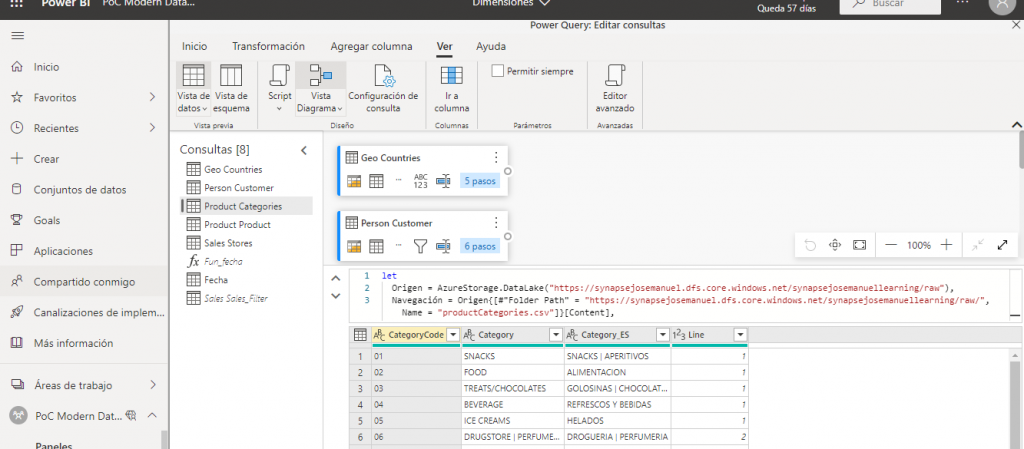

Una vez agregados los diferentes ficheros de datos, procederemos a realizar en power query las distintas transformaciones que necesiten nuestros datos hasta que queden listos para ser consumidos.

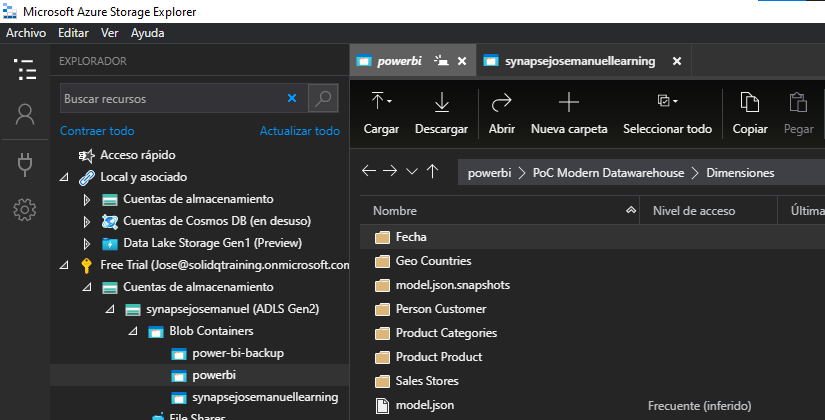

Con el dataflow generado y una vez realizada la actualización del dataflow, podemos comprobar como sus datos son almacenados en el ADLS Gen2 para su posterior uso.

Creación de informe en Power Bi Desktop utilizando como origen nuestros datos preparados para ser consumidos almacenados en el ADLS Gen2

Llegados a este punto, los datos ya preparados para ser consumidos, serán utilizados desde Power Bi Desktop para crear el modelo analítico y poderlos representar visualmente.

Procederemos a crear un nuevo informe. Para especificar el origen de datos del informe, podremos utilizar dos tipos diferentes de conexión:

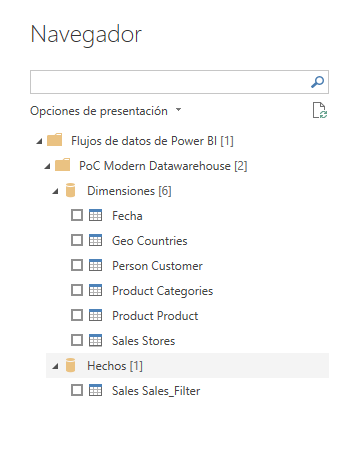

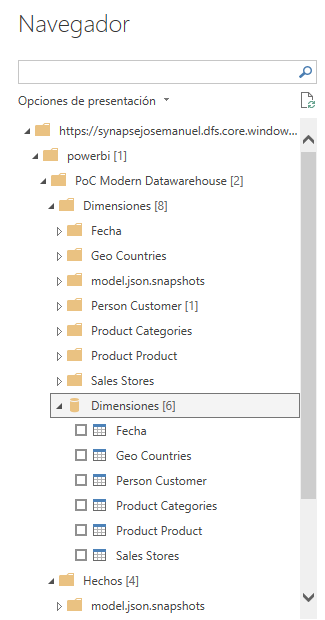

- “dataflow de powerbi”

- Azure Data Lake Storage Gen2

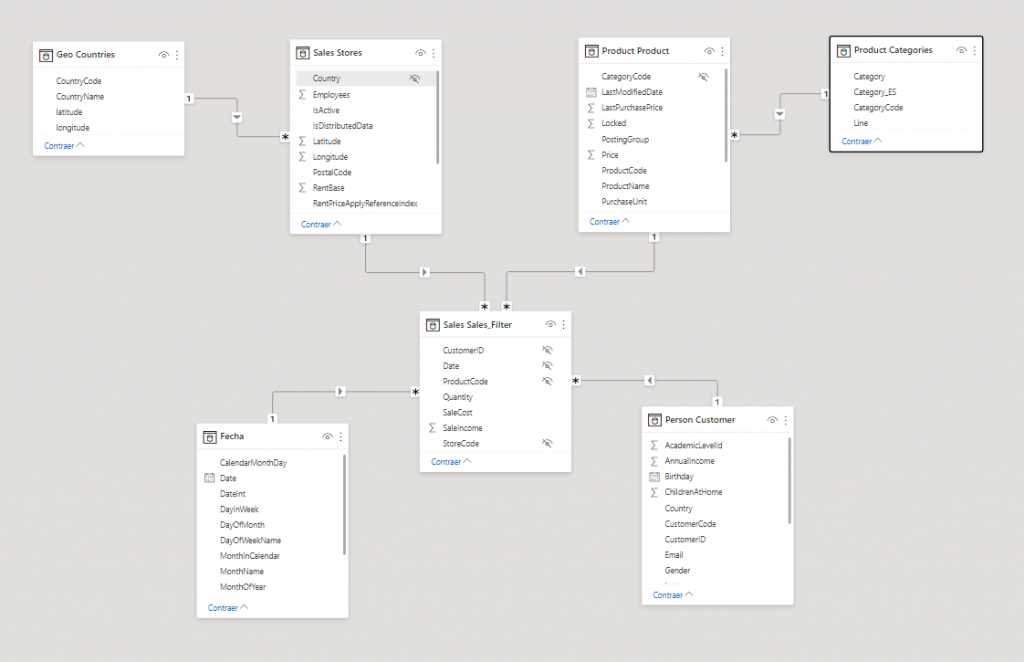

- Realizaremos el modela analítico necesario

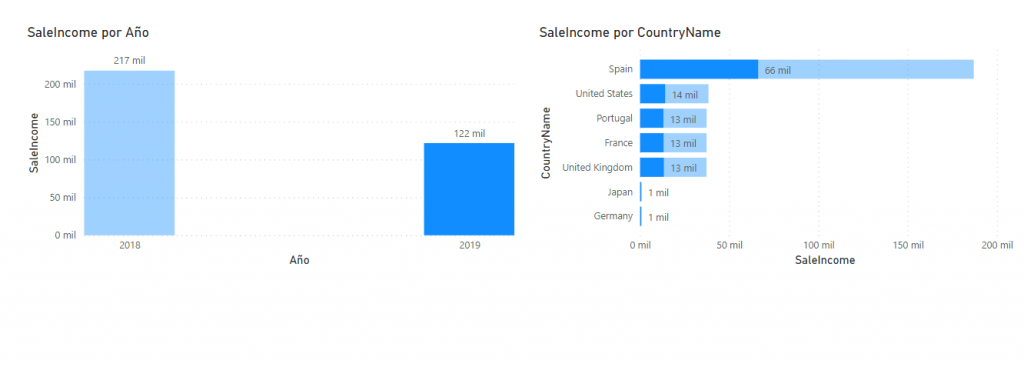

Y representaremos visualmente lo que necesitemos

Enlaces de interés

- Mi compañero Rafael Toledo ya nos explicó en un blog anterior como crear y usar un dataflow. En este enlace puedes leer el post.

- Documentación oficial de Microsoft Configuring dataflow storage to use Azure Data Lake Gen 2

- Whitepapers of Power Bi and Dataflows

Conclusión

Con el planteamiento explicado, conseguiremos tener un modelo de datos centralizado en azure data lake con capacidades para almacenar modelos de big data y que sea accesible por todo nuestro entorno en la nube. Los datos ya no están solo a disposición de los diseñadores de informes de power bi. Las capacidades proporcionadas por el almacenamiento en formato CDM en ADLS Gen2 amplían la utilización de éstos, siendo accesibles por múltiples servicio de datos en Azure y aplicaciones (Azure Data Factory, Azure Synapse Analitics, Azure Databricks, Azure Machine Learning, Dynamics 365, Power BI, Power Platform, etc), permitiendo su uso compartido y reutilización.

¡Sigue Aprendiendo!

Si quieres que te ayudemos a poner en marcha este tipo de proyecto, no dudes en contactar con nosotros. También puedes aprovechar las formaciones existentes para ampliar tus conocimientos 👇🏼

>> Más infoJosé Manuel León Ceballos

Data & AI Architect en Verne Technology Group