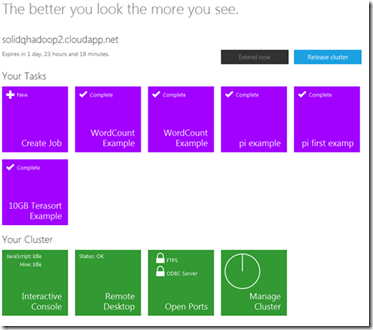

Vamos a conectarnos mediante escritorio remoto a nuestro clúster.Para ello hacemos click sobre el icono de Remote Desktop. Una vez estemos en nuestro clúster, abriremos Internet Explorer, y escribiremos:

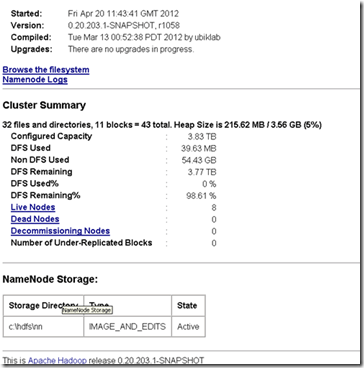

http://NuestraIP:50070/ de esta forma accedemos al namenode mediante la interfaz web, el aspecto de lo que veríamos se muestra en la Figura 2.

Desde la interfaz web podemos acceder al sistema de archivos y navegar por los diferentes archivos y carpetas. Acceder a los logs del name node, ver el estado de nuestro cluster y ver los nodos vivos y muertos.

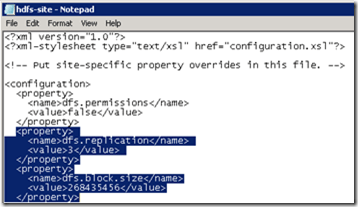

Si editamos el archivo hdfs-site.xml veremos que el factor de replicación esta a 3 (valor por defecto), y tenemos un tamaño de bloque de 256MB. En la Figura 3, se muestra el contenido del archivo hdfs-site.xml

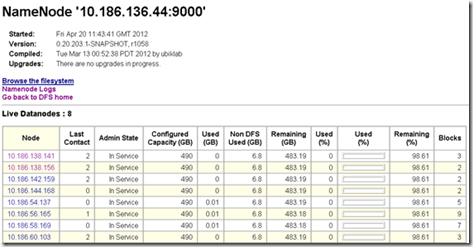

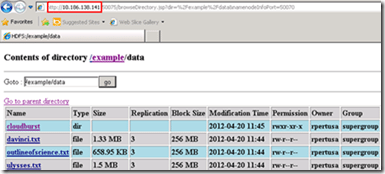

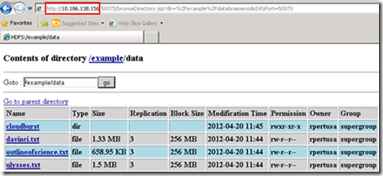

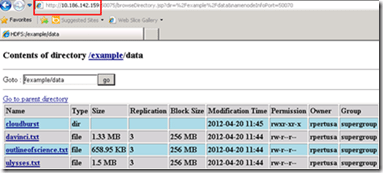

Al navegar entre nuestros directorios podemos verificar que exactamente, el factor de replicación es 3 y el tamaño de bloque es 256MB, ver Figura 4.

En la pantalla principal del Namenode podemos hacer click sobre el enlace Live Nodes, esto nos mostrará una lista de los data nodes disponibles que están asociados al mismo name node:

Cada datanode tiene una IP distinta ya que corresponde con máquinas distintas. Podemos navegar entre las distintas máquinas y comprobar qué contiene cada una de ellas.

Vamos a comprobar por ejemplo que el fichero ulysses.txt se encuentra efectivamente replicado 3 veces en distintas máquinas, podemos comprobar que son máquinas distintas por la IP que nos aparece en la barra de direcciones. Fijese, en las Figuras 6, 7 y 8.

Carga de trabajos al sistema de archivos

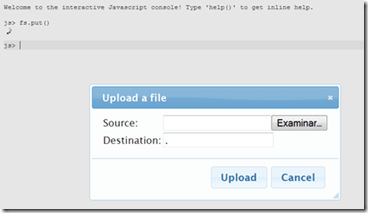

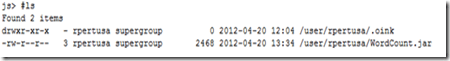

Para cargar archivos al sistema vamos a hacerlo mediante línea de comandos. En la pantalla de inicial de administración del clúster, hacemos click en Interactive Console. Veremos una pantalla básica para poder ejecutar comandos a nuestro clúster y en concreto al sistema de ficheros HDFS. Ejecutamos el comando ls y vemos que sólo nos muestra un archivo.

Cargamos el fichero WordCount.jar, para ello en línea de comandos escribimos el comando fs.put() y presionamos Intro. Hacemos click en examinar, seleccionar el archivo donde lo tengas almacenado y click en ok y luego en Upload, con estos sencillos pasos se procederá a la carga de nuestro archivo al sistema de archivos de HDFS.

Volvemos a ejecutar #ls y vemos como se ha cargado nuestro archivo:

Mediante la consola interactiva de comandos podemos crear directorios, borrar ficheros, mover ficheros, renombrar, etc. de nuestro sistema de archivos.

Hasta aquí esta primera visión sobre Hadoop y su entorno en Azure, profundizaremos en nuevos temas en futuros post.

Post relacionados:

Introducción Hadoop Big Data [parte 1]

Introducción Hadoop Big Data [parte 2]