Finalmente tenemos un cluster kubernetes desplegado mediante kubeadm, pero no disponemos de un mecanismo de persistencia de datos mas allá de los propios discos de almacenamiento de nuestros workernode. Llegados a este punto debemos configurar un sistema de persistencia de datos externo a nuestro cluster, para evitar tener que depender del propio nodo kubernetes para persistir información (mala práctica).

En este post, veremos cómo instalar nuestro servidor NFS para que podamos utilizarlo como sistema de referencia de puntos de montaje desde los workernode de nuestro cluster kubernetes.

Es muy interesante añadir un servidor de ficheros para que kubernetes lo consuma para nuestros storageclass o persistentvolumes. En este post vamos a ver lo fácil que resulta añadir un servidor NFS y que luego lo podamos utilizar como servidor de persistencia de datos local.

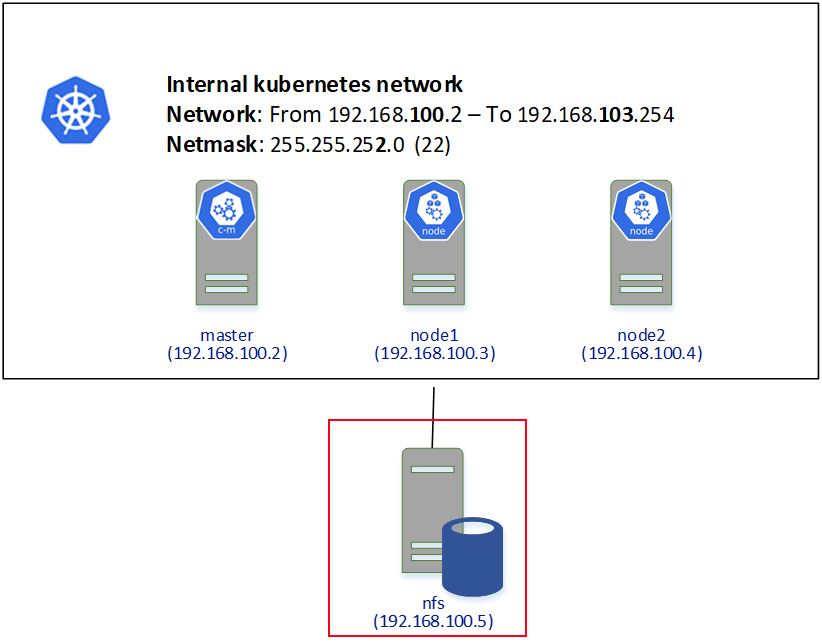

Aquí tienes la arquitectura que queremos montar, donde puedes ver que el servidor NFS se encuentra conectado, pero no forma parte del cluster kubernetes.

NOTA: Te recuerdo que estamos montando un sistema virtual para poder jugar en modo OnPremises con kubernetes. Esta configuración de persistencia no es óptima para producción puesto que no tiene el rendimiento y fiabilidad que seguramente necesites en producción.

Instalar NFS Server

Para instalar el servicio NFS es tan fácil como instalar el paquete nfs-kernel-server

Configurar Servicio NFS

Vamos a configurar para que nuestro servidor kubernetes utilice como persistencia la ruta /export. Para ello la vamos a crear y configurar de la siguiente manera.

Instalar el Cliente NFS en Nuestros Nodos Kubernetes

Para que nuestros StorageClass y PersistentVolumes puedan hacer uso de nuestro sistema de persistencia NFS, tendremos que instalar el cliente NFS en nuestros nodos kubernetes manualmente:

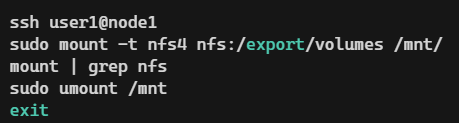

Y finalmente testearemos que efectivamente podemos montar manualmente los volúmenes mediante bash

¿Qué viene ahora?

Pues ahora ya solo nos queda configurar nuestro StorageClass NFS para que podamos utilizarlo en nuestros deployments y que automáticamente persista la información que queramos aquí, pero eso es motivo de otro post.

Aprende todo lo que necesitas saber sobre Kubernetes de cero a Experto

Después del Curso Administración en Kubernetes de 0 a 100, comprenderás los diversos componentes que lo conforman y sus interdependencias, gestionar cargas de trabajo en Kubernetes, configurar tu propio cluster Kubernetes con buenas prácticas... ¡y mucho más!

Voy a Echar un vistazoEnrique Catalá

Soy Technical Leader en Verne TECH, MVP de Microsoft y Microsoft Certified Trainer (MCT). Estoy focalizado en motores relacionales de SQL Server y me encanta resolver problemas de rendimiento y escalabilidad en sistemas OLTP. He liderado más de 100 proyectos, no sólo en España, sino también en otros países como USA, Holanda, México, etc. siendo el principal arquitecto de soluciones como HealthCheck, QueryAnalytics y DatabaseObfuscator.